Künstliche Intelligenz (KI), insbesondere generative KI (Generative Articial Intelligence, GenAI), erleichtert es Übeltätern, ihr Übel zu tätigen: Sie verfasst glaubhafte Phishing-Mails, übersetzt diese in Fremdsprachen, schreibt Schadcode, erzeugt Deepfake-Abziehbilder von Personen etc. Deshalb habe ich mit Security-Awareness-Spezialisten darüber gesprochen, wie sich KI-gestützte Angriffe erkennen und vereiteln lassen.

Letztes Jahr schlug KI-gestützter Betrug erstmals eine richtig hohe Welle: Der Buchhalter einer Bauingenieurfirma hatte nach einer Videokonferenz mit dem CFO und diversen Kollegen 25 Millionen Dollar an Betrüger überwiesen. Denn was er nicht ahnte: Sämtliche Konferenzteilnehmer außer ihm selbst waren Deepfakes.

Derlei KI-generierte Doppelgänger erleichtern nicht nur Finanzbetrug, sondern auch die Infiltration von Unternehmen zu Zwecken der Spionage oder Sabotage. Einen solchen Angriff auf das eigene Unternehmen schilderte der Security-Awareness-Anbieter KnowBe4 letztes Jahr auf seinem Blog: Ein frisch eingestellter Entwickler hatte unmittelbar nach Arbeitsaufnahme unerlaubte Software auf sein Firmen-Notebook geladen. Das SOC-Team (Security Operations Center) bemerkte dies und fragte, ob er Hilfe benötige – und plötzlich herrschte Funkstille.

Der Neuzugang stellte sich bei Nachforschungen als nordkoreanischer Spion heraus, der eine US-Identität gestohlen und das Passbild per KI an sein Aussehen angepasst hatte. Das wachsame SOC-Team hat hier die Kompromittierung verhindert – noch dazu ausgerechnet die eines Security-Awareness-Unternehmens.

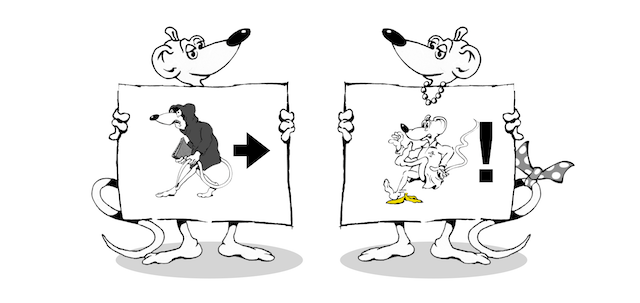

Solche Szenarien – die Deepfake-Konferenz wie auch der nordkoreanische Infiltrator – bilden das ausgetüftelte Ende auf der Skala KI-gestützten Verbrechens. Am anderen, banaleren Ende findet sich der Streuversand KI-generierter oder per KI in die jeweilige Landessprache übersetzter Phishing-Mails, wohl schon bald das Standardvorgehen bei Kompromittierungsversuchen. Irgendwo dazwischen liegt KI-gestützte Bauernfängerei (politisch korrekt „Social Engineering“ genannt) etwa per Messaging-App oder Telefonat. Auch diese Vorgehensweise lässt sich durch KI einfacher und schneller umzusetzen, dürfte sich also künftig häufen.

Auch darauf bot 2024 einen Vorgeschmack: Ein Ferrari-Manager erhielt eine WhatsApp-Message, die scheinbar vom CEO Benedetto Vigna kam. Man wechselte von WhatsApp zum Telefonat, bei dem der Betrüger Vignas süditalienischen Akzent glaubhaft imitierte. Dennoch ließen Unstimmigkeiten den Manager aufhorchen. Dessen eleganter Abwehr-Move: Er fragte sein Gegenüber nach einem Buch, das Vigna ihm kürzlich empfohlen hatte. Da endete der Anruf abrupt.

KI-gestütztes Social Engineering erkennen

Angesichts der letzthin sprunghaften Fortschritte auf dem Feld der KI stellt sich die Frage: Wie erkennt man künftig KI-gestützte Übertölpelungsversuche? „Die Red Flags, die wir von den [Phishing-] E-Mails her kannten, gibt es bei Fake-Videos in der Form in absehbarer Zukunft nicht mehr“, sagt Martin Krämer von KnowBe4. „Wir müssen uns deshalb auf den Kern besinnen: Wie auch immer der Manipulationsversuch geartet ist, es handelt sich letztlich um Social Engineering.“ Bei der Gestaltung der Schulungsmaßnahmen gelte es deshalb, keinen Aktionismus zu schüren, sondern kritisches Denken und tatsächliche Kompetenzen zu trainieren.

Dr. Martin Krämer, Security Awareness Advocate bei KnowBe4.

Bild: KnowBe4

Denn KI hin oder her, Betrug bleibt Betrug, das Grundmuster hat Bestand: Aus Perspektive des Opfers ist es egal, ob man es mit einer KI zu tun hat, mit einem begabten Stimmenimitator oder einfach einem überzeugenden Gauner.

„Beim Social Engineering geht es typischerweise darum, emotionale Trigger auszulösen, ob das Hilflosigkeit ist, Neugier, Habgier, was auch immer“, erläutert Krämer das Procedere. „Es gibt eine klare Aufforderung zu einer Handlung, die mit einer Dringlichkeit versehen wird. Dann wird diese Dringlichkeit eskaliert und die emotionale Einflussnahme verstärkt.“

Der Text einer Phishing-E-Mail mag zwar dank KI glaubhafter wirken und ohne Tippfehler oder sprachliche Mängel daherkommen, aber wichtige Warnzeichen bleiben laut Krämer gleich: „Der Anteil rein textbasierter Phishing-Emails ist sehr gering. Es geht um den Anhang, um das PDF, den QR-Code.“ Die Gefahr des emotional Bequemen

Dennoch fügt KI dem Social Engineering Neues hinzu, und das hat laut Krämer vor allem mit der einfacheren Skalierbarkeit individualisierter Angriffe zu tun. Er bezieht sich dabei auf das Sachbuch „FAIK“ (ein Wortspiel aus „Fake“ für „Fälschung“ und AI, englisch für KI) seines Kollegen Perry Carpenter, das sich um Fake News, Desinformation und KI-gestützte Angriffen dreht: „Die Gefahr ist laut Perry, dass wir immer wieder personalisierten Narrativen ausgesetzt sind, die emotional bequem sind, weil sie plausibel genug sind. Sie müssen nicht unbedingt wahr sein, nur plausibel genug. Damit haben sie große Überzeugungskraft und eröffnen eine Möglichkeit zur Einflussnahme, die tatsächlich auch gefährlich sein kann.“

In Awareness-Kampagnen von Unternehmen darf es deshalb laut Krämer nicht darum gehen, an welchen Unstimmigkeiten man Phishing-E-Mails oder Deepfake-Anrufe erkennt. Vielmehr sollte die Schulung darauf abzielen, das kritische Denken der Belegschaft zu fördern. Oder, wie es Security-Vordenker Bruce Schneier schon seit Jahren predigt: Man braucht einen guten „Bullshit-Detektor“, ein trainiertes Gespür dafür, wenn etwas faul ist.

Wenn der Bullshit-Sensor versagt

Doch Awareness-Schulungen können nicht alle Beschäftigten zum Social-Engineering-Sherlock oder zur Miss Phishing-Marple machen. Deshalb rät Krämer zu komplementären technischen Maßnahmen und Richtlinien.

Er nennt ein Beispiel: „Wenn jemand nicht geschult ist und noch nie was von schädlichen Links in Phishing-Emails gehört hat, dann stelle ich vielleicht die Technik so ein, dass er Links gar nicht erst anklicken kann. Hat er eine initiale Schulung durchlaufen, richtet man es vielleicht so ein, dass eine Vorschau im sicheren Browser angezeigt wird, je nach Lernfortschritt. Hinzu kommt die Frage: Braucht Mitarbeiter X an der Fertigungsstraße unbedingt Zugriff auf sein Email-Postfach, um für diesen einen Zulieferer etwas gegenzeichnen zu können? Oder kann das jemand anders übernehmen? Es geht also auch darum, Prozesse möglichst sicher auszulegen.“

Ist also letztlich die strikte Einhaltung der Prozesse – egal, was der vorgebliche „Chef“ sagt oder schreibt – das Einzige, das hilft? „Das Einzige nicht“, warnt Krämer. Umfasst der Prozess z.B. ein Safe Word, dann könne ein geschickter Social Engineer es durchaus erlangen. „Ob mit Blick auf mehr Flexibilität oder mehr Sicherheit: Es braucht immer das verantwortungsbewusste Handeln“, resümiert Krämer. „Der Prozess allein wird niemanden retten.“ Sein Rat: „Wie auch immer die Prozesse aussehen, man muss sie immer mit Schulungs- und Trainigsmaßnahmen kombinieren.“

Das Problem der schieren Masse

Beim Bochumer Security-Spezialisten G Data CyberDefense, der in seiner G Data Academy Security-Awareness-Schulungen anbietet, stoßen die Fachleute ins gleiche Horn. Die Academy verzeichnet eine stark gestiegene Nachfrage nach Trainings mit den Schwerpunkten KI-Coaching, Social-Engineering-Angriffe wie z.B. QR-Code-Phishing, Deepfakes etc. sowie alles rund um KI-gestützte Betrugsmaschen. Denn diese Angriffe werden immer professioneller – und zugleich leichter skalierbar.

„So etwas verändert natürlich die Trainings, schon durch die schiere Masse“, sagt Matthias Koll von G Data, betont aber, wie auch KnowBe4-Mann Krämer, zugleich die Konstanten wie etwa die Grundintention des Angreifers: „Jemand will abseits eines Prozesses Daten, Geld, Informationen, Zugänge, was auch immer.“

Matthias Koll, Business Owner G Data Academy bei G Data CyberDefense.

Bild: G Data CyberDefense

Auch G Data legt deshalb den Fokus darauf, ganz allgemein Achtsamkeit zu trainieren: „Die Angreifer nutzen immer bestimmte Trigger. Mal ist das der Konformitätswille – man möchte sich korrekt verhalten oder ein Fehlverhalten möglichst schnell ausbügeln –, mal ist es Stress durch Zeitdruck“, so Koll. „Es sind immer die klassischen psychologischen Tricks. Sobald ich erkenne, dass jemand Druck auf mich ausüben möchte, habe ich schon viel gewonnen.“

Im Kontext von Phishing und Social Engineering, etwa bei der aktuellen Masche angeblicher Zahlungsaufforderungen von Amtsgerichten ganz altbacken per Briefpost, sei es deshalb wichtig, sich Zeit zu nehmen und die Lage auf einem anderen Kanal zu verifizieren, hier z.B. per telefonischer Rückfrage beim Amtsgericht.

Achtsamkeit braucht Fehlerkultur

Als Risikofaktor gilt Fachleuten eine Unternehmenskultur nach dem Motto „Was der Chef sagt, wird gemacht“: „Die Unternehmenskultur spielt in diesem Bereich, wie in anderen Bereichen, eine sehr große Rolle“, sagt Koll und betont: „Security Awareness generell funktioniert nur dann, wenn ich eine Kultur schaffe, die es ermöglicht, Fehler zuzugeben.“

Er rät Unternehmen zu langfristigen Security-Awareness-Kampagnen: „Ich ändere menschliches Verhalten nicht, indem ich pro Jahr zwei E-Learnings ausspiele. Ich lerne, indem ich wiederhole, das Gelernte anwende, es als relevant abspeichere und dadurch intrinsisch motiviert bin, es in meine Gepflogenheiten einzubauen. Das schafft ein Unternehmen nur, wenn es kontinuierlich Trainings anbietet und kommuniziert: Wir haben eine Möglichkeit, wie wir uns schützen können.“

Vor diesem Hintergrund hat sich bei G Data der Charakter der Awareness-Trainings gewandelt: „Früher haben wir oft auf einer sehr technischen Ebene mit den Lernern gesprochen: Phishing funktioniert so, da kann man dieses Template sehen und wenn man dieses Makro öffnet, dann passiert dies oder jenes“, berichtet Koll.

Eine heute erläuterte Technik kann aber – nicht zuletzt dank KI – schon morgen veraltet sein. Die menschliche Komponente hingegen hat Bestand. „Es gab auch schon vor dem Internetzeitalter Betrügereien“, sagt Koll. „Deshalb stellen wir inzwischen den Menschen ins Zentrum. Wichtig ist, dass die Lernenden verstehen, wie sie von der peripheren [also der im Alltag üblichen beiläufigen] Wahrnehmung zur kritischen, gezielten Wahrnehmung übergehen. Und dass sie, sobald sie misstrauisch geworden sind, etwas gegen Angriffe tun können.“

Dieses „etwas“ kann – je nach Situation – eine Meldung an den Helpdesk oder das SOC-Team sein, die Frage nach dem im Vorstandskreis vereinbarten Safe Word oder aber einfach die unverfänglich-nonchalant eingeworfene Frage: „Wie hieß gleich wieder dieser Roman, den du mir neulich empfohlen hast?“

Kurz: Natürlich benötigen Unternehmen neben aktuellen Software-Updates sowie Backups eine moderne Abwehrinfrastruktur – und auch diese arbeitet heutzutage KI-gestützt. Ergänzend aber brauchen sie laut Fachleuten durchdachte Prozesse, die sich nur mit hohem Aufwand unterlaufen lassen, und aufmerksame Beschäftigte, die darauf trainiert sind, mit wachem Auge Bullshit zu erkennen – ob KI-generiert oder nicht.

(Der empfohlene Roman war übrigens „Wackelkontakt“ von Wolf Haas. Aber: Psst, nicht weitersagen!)

*****

Hat euch dieser Text gefallen? Dann erzählt doch einem Menschen davon, den das Thema ebenfalls interessieren könnte! Denn liebevoll erstellte Inhalte verbreiten sich am besten per Mundpropaganda.

Cartoon: (c) Wolfgang Traub/Dr. Wilhelm Greiner

Du muss angemeldet sein, um einen Kommentar zu veröffentlichen.