Du weißt, dass der KI-Hype den Gipfel erreicht hat, wenn sogar die „Apotheken Umschau“ das Thema aufgreift. Im Trubel all dieser Gipfelstürmerei verkündet mit HPE ein weiterer Tech-Gigant seinen Einstieg in den KI-Cloud-Markt. Der Konzern betont dabei nicht nur das Potenzial für mehr Produktivität, sondern auch die Nachhaltigkeit seines Angebots.

„Digitaler Arztersatz? Ein Gespräch mit ChatGPT“ titelte kürzlich das erwähnte Fachblatt für den medizinisch interessierten Laien, und schon letztes Jahr: „So könnte KI künftig Krankheiten vorhersagen“. In der Tat gilt künstliche Intelligenz als Hoffnungsträger für die wissenschaftliche Forschung. Längst gibt es erste Erfolge: KI erkennt Parkinson anhand von Veränderungen des menschlichen Atems, lange bevor ein Arzt es könnte; und sie kann Lungenkrebs bei Risikopatienten ein bis sechs Jahre vor Ausbruch der Krankheit vorhersagen.

Im Zentrum gipfelstürmerischen Interesses stehen indes nicht Biomarker-Analysen, sondern generative KI in Form großer Sprachmodelle (Large Language Models, LLMs) wie GPT-3 und -4 (Generative Pre-trained Transformer). Denn auf dieser Transformertechnik basiert das Konversations-Add-on ChatGPT – und der Chatbot hat, weit mehr als alle lebensrettende Medizinforschung, der breiten Masse vor Augen geführt, was mit KI alles möglich ist. So könnten sich Forschungsteams mit KI-Zusammenfassungen viel schneller über den globalen Forschungsstand informieren, als dies manuell möglich wäre.

Nun arbeiten allerdings die wenigsten Menschen an der Speerspitze medizinischer oder sonst irgendeiner Forschung. Manche interessiert an ChatGPT vielmehr: Man kann Hausaufgaben an einen Bot delegieren! Ebenso das Schreiben von Bewerbungen, Blog- oder Linkedin-Posts etc. Mit passendem Prompt Engineering (geschicktes Verfassen der Vorgaben) dient ChatGPT als Planer von Marketing-Kampagnen oder Souffleur für das nächste Date – Cyrano de BergeracGPT. Findige App-Entwickler haben es sogar ermöglicht, den Chatbot für das Beantworten von WhatsApp-Nachrichten heranzuziehen, wenn der Nutzer dazu intellektuell nicht in der Lage oder schlicht zu faul ist. Das Einsatzspektrum der KI scheint unbegrenzt: Es reicht von grenzenlos hilfreich bis grenzenlos bescheuert.

Neben dem Risiko bequemlichkeitsbedingter Verblödung – als Deutscher und damit amtlich zertifizierter Bedenkenträger fühle ich mich zu diesem Hinweis verpflichtet – birgt generative KI weitere Risiken. Zunächst: ChatGPT halluziniert. Der ChatBot ist eine Konversations- und keine Wahrheitsmaschine. Da die Antworten aber so überzeugend klingen, übernehmen viele Nutzer sie ungeprüft, was der Verbreitung von Falschnachrichten Tür und Browserfenster öffnet. Die unerträgliche Leichtigkeit des Prompts dürfte eine Flut KI-generierter Inhalte bewirken. Die zunehmende Schwierigkeit, KI-generiertes von echtem Material zu unterscheiden, kulminiert wiederum schnell in Misstrauen und Desinteresse. Beides nagt am gesellschaftlichen Zusammenhalt – von gezielten Fake-News-Kampagnen ganz zu schweigen.

Und schließlich: Delegiert der Mensch etwas an Hard- oder Software, steigt stets der Energieverbrauch. Das galt schon für Dampfmaschine und Verbrennermotor, es gilt heute für vollautomatisierte Robotik am Fließband ebenso wie für die vollautomatisierte Fließbandproduktion von Bot-Texten. Hochrechnungen gehen davon aus, dass das Training – wohlgemerkt: nur das Training, nicht die Nutzung – von OpenAIs GPT-3 500 Tonnen CO2 erzeugt hat, das von Metas Konkurrenzmodell OPT hingegen „nur“ 75 Tonnen. Ein Forschungspapier der University of Massachusetts in Amherst ergab 2019: Das Training eines einzigen KI-Modells kann so viel CO2 erzeugen wie fünf Autos über deren gesamten Lebenszyklus hinweg. Fünf US-amerikanische Autos!

Digitale Blechlawine

Ein KI-Modell ist noch kein Problem, ebenso wenig fünf PKW. Diese aber wachsen zur endlosen Blechlawine, wenn Hinz und Kunz anfangen, in jeder Lebenslage KI zu nutzen, zeitgleich mit der Hinz AG und der Kunz GmbH, den Behörden von Hinzenheim und Kunzenhausen sowie natürlich Klein-Hinzchen und Klein-Kunzchen für ihren Schul- und Smartphone-Daddel-Alltag. Dank Cloud skaliert das global: Kunzenhausen ist überall.

Der Kunzenhausener Alltag ist keine ferne Zukunftsmusik mehr: „2023 wird als historische Zeitenwende in Erinnerung bleiben“, sagte Antonio Neri, President und CEO von HPE, jüngst bei seiner Keynote auf HPEs Kundenveranstaltung Discover in der Carbon-Footprint-Hölle Las Vegas. Neri rückte natürlich vor allem die Vorteile der KI für HPEs Unternehmensklientel in den Fokus: „KI schafft Superkräfte für Ihr Business“, sagte er.

Keine Superkräfte ohne Supercomputer. HPE ist seit der Übernahme von Cray 2019 eine große Nummer im Supercomputing-Business: HPEs Frontier-System durchbrach letztes Jahr als erster Großrechner die Exascale-Schallmauer. Frontier, gebaut für das Oak Ridge National Laboratory (ORNL) des US-Energieministeriums, belegt seither Platz 1 der Top500-Liste der supersten Superrechner. Zugleich eroberte er als energieeffizientester Großrechner Platz 1 der Green500-Liste, heute liegt er hier auf Platz 2.

Einstieg in den KI-Cloud-Markt

Mit dieser Rechenpower im Gepäck verkündete Neri auf der Discover: HPE steigt in den KI-Cloud-Markt ein. Sein Konzern tritt damit in Konkurrenz zu Cloud-Größen wie AWS, Google und Microsoft sowie zu Open-Source-Lösungen und IBM, mit Watson ein Veteran im „KI as a Service“-Markt.

HPEs neues Angebot GreenLake for LLMs (Large Language Models) soll es Unternehmen jeder Größe ermöglichen, KI per multimandantenfähiger Supercomputer-Cloud zu trainieren, zu optimieren und zu nutzen. Hierbei setzt HPE auf den deutschen KI-Spezialisten Aleph Alpha. Das Unternehmen aus Heidelberg bietet mit Luminous ein multimodales KI-Modell: Luminous kann Texte wie auch Bilder verwerten. GreenLake for LLMs gibt Anwendern Zugang zu dem vorab trainierten LLM von Aleph Alpha, verfügbar auf Deutsch, Englisch, Französisch, Italienisch und Spanisch. Die Pointe, wie bei so vielen neueren KI-Angeboten: Das Anwenderunternehmen kann das vortrainierte Modell nutzen, um mit internen Daten sein eigenes zu trainieren.

Anders als generische Public Clouds, so HPE, beruhe GreenLake for LLMs auf einer Architektur, die speziell für eine große KI-Trainings- und Simulationsumgebung konzipiert ist: GreenLake for LLMs wird auf Cray-XD-Supercomputern laufen. Das Angebot unterstütze KI- und HPC-Aufgaben (High-Performance Computing) auf Hunderten oder Tausenden CPUs oder GPUs gleichzeitig. Dies mache das KI-Training wesentlich effizienter und erlaube es, präzisere KI-Modelle zu entwickeln, so HPE. GreenLake for LLMs soll noch dieses Jahr in Nordamerika auf den Markt kommen, Europa soll Anfang 2024 folgen.

Enormes Potenzial von KI

Neri lud Gäste zur Podiumsdiskussion zu KI. Hier herrschte erwartungsgemäß große Einigkeit über deren Potenzial. „Generative KI ist der Anfang einer neuen Ära“, sagte Aleph-Alpha-Chef Jonas Andrulis. Generative KI, so Andrulis, werde die Welt wirklich verändern. Doch es gelte, die Zusammenarbeit zwischen Mensch und Maschine neu zu erfinden und auch das Verständnis „korrekter“ KI-Antworten weiterzuentwickeln.

Chase Lochmiller von Crusoe Energy argumentierte, KI könne Menschen in allen Bereichen zehnmal so produktiv machen, von der Softwareentwicklung bis zum Marketing. Der Hauptwert für Unternehmen liege darin, hausinterne Expertise mit der Power von LLMs zu kombinieren. Doch er warnte: „Heute machen Rechenzentren ein bis 1,5 Prozent des globalen Stromverbrauchs aus, aber KI wird das über zehn Prozent hinaustreiben.“ Dies werde die Klimakrise befeuern. Crusoe verfolgt deshalb das Ziel, „gestrandete“, also überschüssige Energie aus anderen Industrien für RZs nutzbar zu machen.

Nachhaltigkeit vs. KI

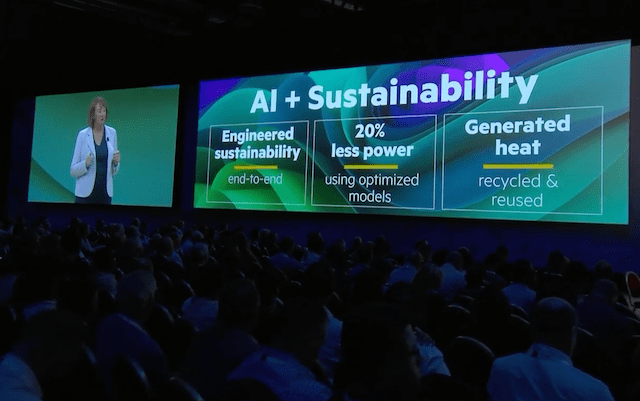

Dem Klimadilemma versucht HPE zunächst mit Ingenieursarbeit zu begegnen: „Unsere Ingenieure bauen Nachhaltigkeit von Anfang bis Ende ein“, so CTO Fidelma Russo in ihrer Keynote mit Blick auf Aspekte vom Server-Design bis zur Flüssigkeitskühlung. Zudem werde man GreenLake for LLMs nur in umweltfreundlichen, energieeffizienten Colocation-Rechenzentren betreiben – schon aus schnöden monetären Gründen eine gute Wahl.

Den Anfang macht ein Colo-RZ von QScales in Lévis, einem Vorort der kanadischen Stadt Québec. Dieses läuft nach QScales-Angaben zu 99,5 Prozent mit Strom aus erneuerbaren Quellen, vorwiegend Wasserkraft, liegen Québec und Lévis doch direkt am Saint-Lawrence-Strom. Der kanadische Colo-Betreiber bemüht sich laut eigenen Angaben, Abwärme zurückzugewinnen und wiederzuverwenden. Außerdem, so QScales, eigne sich Québec zu 80 Prozent des Jahres für freie Kühlung. Und HPE hat sicher Ideen, wie man den RZ-Betrieb per KI-Analysen noch umweltfreundlicher gestalten kann.

Trotz aller Bemühungen der KI-Größen und Cloud-Betreiber: Der Carbon Footprint der globalen KI-Industrie wird durch die Decke schießen, wenn ein Teil der Menschheit künftig jeden Handgriff und Denkvorgang an ChatGPT & Co. auslagert. Und das wird passieren, ich kenn’ doch meine Hinzenheimer. Zum Glück folgt laut Gartners Hype Cycle auf den Hype-Gipfel stets das Tal der Enttäuschung. Und vielleicht wird man ja eines Tages mittels KI ein Heilmittel gegen exzessive KI-Abhängigkeit entwickeln. Dann könnte eine Anzeige in der „Apotheken Umschau“ lauten: „KI-Sucht – Gibt’s da nicht was von Ratiopharm?“

*****

Hat Ihnen dieser Text gefallen? Dann erzählen Sie doch einem Menschen davon, den das Thema ebenfalls interessieren könnte! Denn liebevoll von Hand erstellte Inhalte verbreiten sich am besten per Mundpropaganda.

(Dieser Beitrag erschien in einer etwas längeren Fassung kürzlich auf LANline.de.)

Du muss angemeldet sein, um einen Kommentar zu veröffentlichen.