Je nachdem, wen man fragt, ist künstliche Intelligenz (KI) die revolutionärste Neuerung seit der Erfindung des Rads, des Internets oder zumindest des veganen Scheiblettenkäses. Quer durch alle Branchen planen Unternehmen, mit KI ihre Prozesse eleganter zu orchestrieren, sei es per Auswertung von Massendaten durch ML (Machine Learning) oder die optimierte Mensch-Maschine-Interaktion mittels generativer KI, beispielsweise ChatGPT. AIOps-Lösungen (Artificial Intelligence for IT Operations) sollen dafür sorgen, dass die IT ohne großen Aufwand nach der Pfeife des Administrators tanzt.

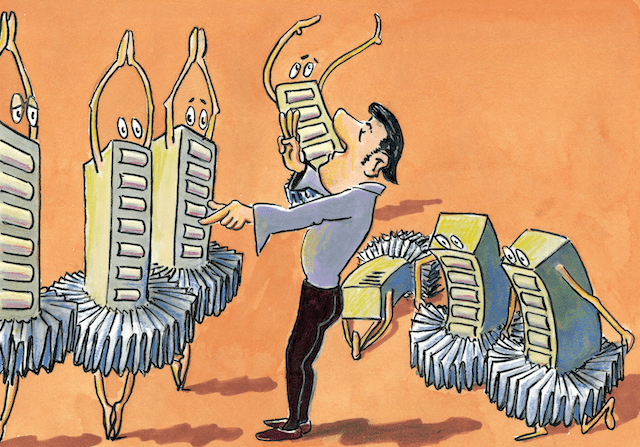

Stichwort „Tanz“: Die letzte große Bastion des Musicals ist der Animationsfilm. Ein Paradebeispiel liefert Disneys „Der König der Löwen“: Als Nachwuchslöwe Simba seinen Anspruch auf Herrschaft im Tierreich proklamiert, bilden die anderen Tierarten in einer Musical-Revuenummer eine Pyramide aus ihren Körpern, auf deren Spitze Simba dann sein „I just can’t wait to be king“ schmettert. Nach der Durchsage fällt die Pyramide wieder in sich zusammen.

Derlei agile Pyramidenbildung nennt man in IT-Kreisen „Intent-based Provisioning“ (absichtsbasierte Bereitstellung): Eine KI ermittelt aus verbal formulierter Absicht den Ressourcenbedarf und orchestriert die Ressourcen automatisch – nur eines von unzähligen Beispielen dafür, wie die Branche das IT-Management per KI optimieren will.

Symbolische Systeme, neuronale Netze

Es gibt aber nicht die „eine“ KI. Zwei prominente Varianten: erstens symbolische Systeme (mit der Annahme, dass KI wie Logik oder Programmierung funktionieren sollte), auf denen die heute verbreiteten Expertensysteme und Wissensgraphen beruhen, zweitens neuronale Netze (Deep Neural Networks oder DNNs, mit dem menschlichen Gehirn als Vorbild).

Letzthin dominieren DNNs die Diskussion, und dies in diversen Bereichen: die Verarbeitung natürlicher Sprache zum Beispiel bei Siri, Alexa oder Google Assistant; Bilderzeugung etwa mittels Dall-E, Stable Diffusion oder Midjourney; zudem die Texterstellung mittels großer Sprachmodelle (Large Language Models, LLMs) wie GPT (Generative Pre-trained Transformer) von OpenAI, auf dem die populäre Konversations-KI ChatGPT beruht.

GPT ist, wie der Name schon sagt, ein Transformer, also ein DL-Modell (Deep Learning, eine Variante des Machine Learnings oder ML), das mittels eines Verfahrens namens Self-Attention die Bedeutung von Input eigenständig gewichtet. ChatGPT hat der breiten Öffentlichkeit das Potenzial von KI vor Augen geführt; der Chatbot erscheint geradezu als Flaschengeist aus dem Disney-Film „Aladdin“: Aus wenigen Prompts (Vorgaben) erzeugt der Djinn, im Original gesprochen vom genialen Standup-Komiker Robin Williams, einen Wirbelwind vielfältiger Ergebnisse. Dabei ist ChatGPT im Grunde nur eine Autocomplete-Funktion, die dank LLM-Training sehr weit vorausplant. Google hat mit Bard kürzlich ein Konkurrenzangebot vorgestellt, das in manchen Punkten ChatGPT überflügeln soll.

Flaschengeist für den IT-Betrieb

Einen Flaschengeist hätte der geplagte IT’ler auch gern. Zum Glück arbeitet die IT-Branche schon lange am KI-gestützten IT-Betrieb: Anbieter wie IBM, HPE, Splunk oder die Hyperscaler sammeln seit Jahren Telemetriedaten ihrer Geräte und Lösungen. Denn es erfordert einen riesigen Datenpool, um KI/ML-Modelle für AIOps zu trainieren. Erstes Ziel war oft das Aufspüren von Ausreißern oder Clustern, um Störungen zu erkennen und möglichst früh zu prognostizieren (Predictive Maintenance). Aus einer Wissensdatenbank lassen sich dann ebenfalls per KI Lösungsvorschläge generieren (Prescriptive Maintenance).

ML und DL eröffnen noch viele weitere Einsatzfelder, vom Incident-Management inklusive Fehlerursachenanalyse über die (semi-)autonome Provisionierung bis zur Angriffsabwehr mittels EDR, NDR oder XDR (Endpoint/Network/Extensible Detection and Response). Chatbots wie ChatGPT und Bard könnten Aufgaben am Service-Desk übernehmen und letztlich die First-Level-Belegschaft ersetzen, so die – je nach Blickwinkel – Hoffnung oder Befürchtung.

Im Zusammenspiel mit OpenAIs Code-Generator Codex übernimmt ChatGPT auch das Schreiben von Code und Skripten, um IT-Abläufe zu automatisieren. Und da Bard – ebenso ChatGPT mit Plugins – Zugriff auf das Internet hat, können Entwicklungsteams sich zum Beispiel die Funktion von Codebausteinen auf GitHub erläutern lassen, um ihre Arbeit zu erleichtern. Abfragen von Wissensdatenbanken kann ein KI-Bot ebenso bewerkstelligen wie Status-Reports und deren Übersetzung in Fremdsprachen oder eine Management-gerecht einfache Sprache für IT-Fremde.

Und so malen manche Anbieter ein zauberhaftes Bild, in dem KI alle lästigen Aufgaben übernimmt und das IT-Team nur noch den Taktstock schwingen muss, damit das Server-Balett einen Pas de deux auf der Hybrid-Cloud-Bühne tanzt. Weil der IT-Alltag aber weder Ponyhof noch Disney-Film ist, stellen sich den erwartungsvollen IT-Dirigenten noch Hindernisse in den Weg. Und diese erweisen sich oft als ebenso hartnäckig wie Simbas machthungriger Onkel Scar oder Aladdins Widersacher, der finstere Großwesir Jafar.

Widerspenstige Gegenspieler

„Wie bei jedem KI-Modell sind AIOps-Anwendungen abhängig von der Qualität der Daten, die sie empfangen“, erläutert Isabell Sippli, Distinguished Engineer im Bereich AIOps bei IBM. Doch im IT- und Netzwerkbetrieb seien diese Daten oft heterogen und unvollständig.

„Außerdem gibt es nur sehr wenig ,Ground Truth’, also einen Goldstandard, der beschreibt, welche möglichen Ergebnisse einer KI richtig oder falsch sind“, führt Sippli aus und nennt als Beispiel die automatische Event-Korrelation: „Dafür gibt es keine öffentlich verfügbaren ‚Labeled Data Sets‘ (annotierte Datensätze, d.Red.), die es uns erlauben zu vergleichen, welche Events richtig korreliert sind oder nicht.“

„AIOps ist nicht exakt definiert und kein besonders großer Bereich, verglichen mit einigen anderen KI-Einsatzgebieten“, sagt Sascha Giese, Head Geek bei SolarWinds. „Daher kann man auf kein vordefiniertes Framework zurückgreifen oder gar eines von der Stange kaufen.“ Fehlentscheidungen könnten aber ernsthafte Konsequenzen für die IT eines Unternehmens haben. Daher seien Kontrollmechanismen erforderlich, so Giese.

„Wenn für das Training nicht genug Daten zur Verfügung stehen, wenn die Daten irrelevant oder nicht vielfältig genug sind, werden die Ergebnisse unbrauchbar“, bestätigt Axel Simon, Chief Technologist DACH bei HPE Aruba Networking. „Actionable AIOps – die Kombination aus KI und Automatisierung – muss also umfassend genug sein, um individuelle Kundenprobleme schnell und präzise identifizieren und lösen zu können.“ Grundlage dafür sei ein Data Lake, in den Netzwerkerkenntnisse einer möglichst großen Vielzahl von Installationen einfließen.

Start mit dem fliegenden Teppich

Disney-Titelheld Aladdin entdeckt zufällig, dass die Zauberlampe durch Reiben den Djinn freisetzt, der seine Wünsche erfüllt. Die IT-Anbieter hingegen mussten jahrelang forschen, um den AIOps-Teppich zum Fliegen zu bringen. „Wir haben das Glück, seit vielen Jahren im AIOps-Geschäft und damit zusammenhängenden Bereichen wie Operations-Management und Monitoring zu sein, sodass wir gute Arbeitsbeziehungen zu großen Kunden weltweit haben, die uns helfen, unsere Modelle mit Beispieldaten zu validieren“, so IBM-Ingenieurin Sippli. Zudem hat IBM natürlich Zugriff auf hauseigene Daten seiner Teams.

„Wir glauben auch, dass Foundation Models Chancen in bestimmten Bereichen von AIOps bieten, um einige Herausforderungen zu überwinden“, sagt Sippli. Foundation Models sind Basismodelle, auf denen sich einsatzspezifische aufbauen lassen. IBM hat kürzlich mit Watsonx entsprechende Lösungen vorgestellt.

„Die Entwicklung und das Training unserer KI haben etwa zwei Jahre gedauert“, erzählt SolarWinds-Experte Giese. „Hauptsächlich haben wir unsere eigenen Daten genutzt, konnten aber auch auf externe Daten von Pilotprojekten zurückgreifen.“

Die Fortschritte beschreibt er anhand eines Beispiels: „Früher wurde ein Alarm ausgelöst, wenn ein Volume zu 85 Prozent gefüllt war. Das war zum Zeitpunkt von 1-TByte-Drives ein guter Wert, jedoch hat sich die Technologie weiterentwickelt.“ Also habe man eine Zusatzbedingung definiert: 85 Prozent und einen statischen, von der Volume-Größe abhängigen Wert an verfügbarem Speicherplatz. So habe man unnötige Alarme verringern können.

„Mittlerweile“, so Giese, „nutzen wir Regressionsmodelle zur dynamischen Vorhersage der Auslastung in Kombination mit den oben aufgeführten Beobachtungen, zum einen, um ein Sicherheitsnetz aus redundanten Auslösern zu haben, zum anderen, um die Anzahl an Alarmen weiterhin zu minimieren.“

„Splunk Enterprise und Splunk Cloud bieten umfassende Möglichkeiten, Daten aus heterogenen Quellen einzulesen, diese flexibel mithilfe der Suchsprache SPL (Search Processing Language) auszuwerten und in KI-Modelle zu übersetzen“, sagt Philipp Drieger, Global Principal Machine Learning Architect bei Splunk. Für AIOps habe man die Lösung IT Service Intelligence um vordefinierte KI-Funktionen ergänzt.

HPE-Experte Simon hebt die Bedeutung der Datenbasis hervor: „Unsere Domainexpertise basiert auf einem Data Lake von Aruba-Central-Nutzern mit über 31 TByte Messdaten pro Tag“, sagt er. „Sie stammen von zig-tausenden Installationen in allen Unternehmensgrößen, Branchen und Regionen weltweit.“ Die KI-Engine in der Cloud wisse somit jederzeit für jedes Anwenderunternehmen, wie gut das Netzwerk läuft.

Risiko Fata Morgana

Was Nutzer immer wieder erstaunt: Einerseits liefert ChatGPT fabelhafte Ergebnisse, bis hin zum bestandenen Anwaltsexamen; andererseits erzählt sie manchmal abstruse Märchen, in Fachkreisen „Halluzinationen“ genannt. Der Hintergrund: Während symbolische Systeme auf Logik aufbauen und damit verlässliche Ergebnisse liefern, schafft eine generative KI selbstlernend neue Inhalte. Und ChatGPT ist eben eine Konversations- und keine Wahrheitsmaschine: Die Autocomplete-Fee aus 1.001 Nacht kümmert es nicht, ob das Ergebnis Fakt oder Fiktion ist – Hauptsache, die Antwort klingt so, als käme sie von einem Menschen. Verlässt man sich im IT-Betrieb allzu leichtfertig auf den fliegenden KI-Teppich, droht somit ein Flug mit Turbulenzen.

„Eine AIOps-Lösung sollte nicht halluzinieren, da das dramatische Auswirkungen haben könnte“, betont Sippli von IBM, „zum Beispiel wenn sie einen fehlerhaften Lösungsansatz empfehlen würde, der das Problem verschlimmert und den Incident verlängert.“ Doch wie lässt sich das verhindern? „Best Practices bei IBM AIOps beruhen auf einem soliden Forschungs- und innovativen Engineering-Konzept rund um Large Language Models sowie auf einem proprietären Ansatz, den IBM erforscht, um LLMs mit anderen, nicht-generativen KI-Methoden zu kombinieren.“

Zwei Dimensionen zur Kontrolle von Halluzination seien „Helpfulness“ (Nützlichkeit) und „Harmlessness“ (Harmlosigkeit): „Unser Hybridansatz ermöglicht es uns, den richtigen Sweet Spot entlang dieser beiden Dimensionen zu erreichen“, so Sippli. Es sei ratsam, Benutzern von AIOps-Software aufzuzeigen, wo welche KI zum Einsatz kommt, damit sie das Risiko einschätzen können.

„Unser KI-Modell nutzt natürliche Sprache zur Darstellung von Ergebnissen“, beruhigt HPE-Mann Simon. „Dieses Wirkprinzip meidet das Ersetzen von Fakten durch Fiktionen oder KI-Halluzinationen. Wenn also die KI sagt, dass ein bestimmtes Endgerät ein Roaming-Problem hat, dann ist das eine verständliche Übersetzung einer vorausgegangenen Auswertung von Messwerten.“ Die resultierende Empfehlung basiere auf dem Vergleich erfolgreich umgesetzter Lösungen bei einer Vielzahl von Anwenderunternehmen.

Auch SolarWinds-Mann Giese schätzt das Halluzinationsrisiko beim hauseigenen Ansatz als gering ein: „Glücklicherweise bewegen wir uns in einem Bereich, der zu 100 Prozent auf Zahlen basiert und definierbar ist“, sagt er. „Selbstverständlich kann es auch hier zu interessanten Fällen kommen, aber das Risiko von klassischen Halluzinationen wie bei einer generativen KI ist vernachlässigbar.“

Eine Frage des Vertrauens KI – insbesondere generative KI – ist aus Nutzersicht eine Blackbox: Man weiß nicht, wie der Djinn sein Ergebnis herbeizaubert. Dies sorgt für Misstrauen. Generative KI lässt sich aber auch darauf trainieren, ihren Lösungsweg zu erklären. So bemühen sich die AIOps-Anbieter um Mechanismen, um Einblick in die Vorgehensweise ihrer KI zu geben.

„Wir bieten als Teil unserer Lösungen Explainability (Erklärbarkeit, d.Red.) und Transparenz an“ sagt IBM-Expertin Sippli. „Zum Beispiel erklären wir, wie die Lösung zu bestimmten Schlussfolgerungen gekommen ist“ – etwa per Nachweis historischer Event- oder Ticketdaten, die Korrelationen oder Handlungsempfehlungen begründen. „Darüber hinaus bieten wir den Betriebsexperten Einsicht und Kontrolle bei der Anwendung von KI-basierter Automatisierung, um beispielsweise zu bestätigen, was sicher ist“, so Sippli. Erkenntnisse aus diesen Entscheidungen ziehe man dann für künftige KI-Interaktionen heran.

„Um bessere Ergebnisse zu erzielen, sind die Rückkopplung und die Validierung der Ergebnisse eines KI-Modells durch einen Analysten zentral“, sagt auch Splunk-Fachmann Drieger. Der Anwender ist somit Teil des Gesamtsystems, indem er der KI Rückmeldung gibt. Mit diesem Ansatz, RLHF (Reinforcement Learning from Human Feedback) genannt, arbeiten auch KIs wie ChatGPT. „Erstellte KI-Modelle können genauer untersucht werden, um damit eine bessere Nachvollziehbarkeit zu gewährleisten“, so Drieger. Zudem biete Splunk in der Regel die Option, bis auf die Rohdatenebene zu gehen, was für detaillierte Analysen und die Nachvollziehbarkeit unerlässlich sei.

Letztlich ist und bleibt es offenbar die wichtigste AIOps-Vertrauensmaßnahme, dem IT-Fachpersonal trotz aller Automationsmöglichkeiten das letzte Wort zu überlassen: „Die integrierte Automatisierung“, so HPE-Fachmann Simon über die Aruba-Lösung, „zeigt in natürlicher Sprache das Problem nachvollziehbar an und überlässt dem Anwender den Grad der Automatisierung und die Abstufung in Prioritäten.“

KI im Cybercrime und im SOC

Als der böse Onkel Scar im „König der Löwen“ seine Machtergreifung plant, fährt Disney alles auf, was die Szene unheimlich wirken lässt: Scars Anhänger, eine Horde debiler Hyänen in einer gelblich-verrauchten, skelettübersäten Höhle, formieren sich im Lauf seiner Rede zu einem Heer im Stechschritt marschierender Raubtiere. Die Szene, eine Zeichentrickvariante von Leni Riefenstahls NSDAP-Parteitagsfilm „Triumph des Willens“, dient als düsteres Gegenstück zur Tierpyramide des „guten“ Simba – ist aber letztlich deren Spiegelbild: In beiden Fällen werden die Körper der Untergebenen in strenge Formation gezwängt, um Machtansprüche zu untermauern. Kurz: Machtinstrumente lassen sich ge- oder missbrauchen – doch die Grenze ist nicht so klar, wie sie erst scheint.

Eine solche Doppelrolle spielt auch KI, etwa im Security-Bereich: Die Cybercrime-Pendants zu Scar, Jafar und Co. ziehen für ihre dunklen Machenschaften zunehmend KI-Tools heran, um beispielsweise Phishing echter wirken zu lassen. Die Verteidiger wiederum setzen zur Angriffs- und Malware-Erkennung schon längst auf ML.

Auch generative KI könnte im SOC (Security Operations Center) punkten: „SOC-Teams sind in der Regel mit unzähligen zeitaufwändigen manuellen Aufgaben konfrontiert, bei denen generative KI helfen kann, Prozesse zu automatisieren, indem sie schnell entsprechenden Code schreibt“, sagt Bert Skaletski, Resident CISO EMEA bei Proofpoint. „Generative KI kann auch technischen Fachjargon in für Laien verständliche Sprache umformulieren und so die Kommunikation des SOC-Teams mit den Endbenutzern persönlicher gestalten und verbessern.“ Ebenso könne sie beim Schichtwechsel im SOC den Informationstransfer zwischen Teams erleichtern.

Doch auch hier stößt KI an Grenzen: „KI-Technologie ist extrem gut darin, große Mengen von Daten zu verarbeiten, Muster und Abweichungen zu erkennen. Nach wie vor ist jedoch ihre Fähigkeit, Daten und Ereignisse kontextuell zu beurteilen, nur rudimentär vorhanden“, so Skaletski. „Weil diese Urteilsfähigkeit noch immer zu wünschen übriglässt, kommt es regelmäßig zu falsch-positiven oder falsch-negativen Ergebnissen bei der Erkennung.“ Daher bedürfe es im SOC weiterhin einer Kombination aus menschlichem Fachwissen und KI-gestützten Systemen.

Djinn mit zwei Gesichtern

Der KI-Geist ist aus der Flasche, und seine Kräfte können praktisch überall zum Einsatz kommern. In Form von AIOps bittet KI die IT-Welt zum Tanz, während im Darknet eine Cybercrime-Szene, die es mit sämtlichen Disney-Bösewichtern aufnehmen kann, den Djinn für Angriffe nutzt. Aus „Aladdin“ wissen wir: Wie nützlich der Flaschengeist ist, hängt davon ab, wie geschickt die Prompts formuliert sind. „Der König der Löwen“ wiederum lehrt uns, dass Gebrauch und Missbrauch von Machtinstrumenten näher beieinanderliegen, als es scheint – und dies in Zeiten rasanter KI-Fortschritte.

Manche Fachleute plädierten deshalb bereits für ein Moratorium in der KI-Entwicklung – was jedoch ähnlich fantastisch klingt wie eine Pyramide aus Elefanten und Giraffen. Vermehrt hört man zudem die Forderung, KI müsse – wie jede gemeinwohlrelevante Innovation bisher – staatlicher, möglichst internationaler Kontrolle unterliegen. Denn da generative KI enorm große Datenpools und Rechenpower voraussetzt, kann sich nur eine Handvoll Konzerne, allen voran Microsoft und Google, das Training der Foundation-Modelle leisten – und ob diese mächtigen Player letztlich das Gemeinwohl oder doch nur den Profit im Auge haben, will man nicht erst herausfinden, wenn sich der Dirigent des Djinns als böser Onkel und machtgeiler Großwesir entpuppt.

(Dieser Beitrag erschien erstmals in LANline 06/2023.)

Lust auf mehr Artikel dieser Art? Nichts leichter als das! Einfach hier den IT Info 2 Go Newsletter abonnieren! (Achtung: Double-Opt-in wg. DSGVO! Es kommt also eine E-Mail mit Link zur Bestätigung, deshalb bitte ggf. Spam-Ordner checken!)

Bild: (c) Wolfgang Traub

Du muss angemeldet sein, um einen Kommentar zu veröffentlichen.