Neben einer wohlorganisierten Abgreiferszene, dem längst überfälligen Schließen alter Sicherheitslücken, Angriffen auf die digitale Lieferkette sowie Ransomware & Co. setzt nun auch noch künstliche Intelligenz (KI) etwa in Form von ChatGPT die Verteidigerseite unter Druck. Erstaunlicherweise lassen sich die Chancen und Risiken der veränderten IT-Sicherheitslage am besten anhand der Werke des britischen Liedermachers Billy Bragg erklären.

„Talking with the Taxman about Poetry“ („Gespräche mit dem Steuereintreiber über Dichtkunst“) lautete 1986 der geniale Titel einer Billy-Bragg-Schallplatte. (Junge Leser*innen, denen der Begriff „Schallplatte“ nichts mehr sagt, möchten bitte ihre Großeltern oder aber den nächstbesten Mann mit Hipster-Vollbart dazu befragen.) Das Wunderbare an dem Albumtitel ist die augenzwinkernde Ambivalenz: Warum sollte man eigentlich nicht mit einem Finanzbeamten über Poesie sprechen wollen? Und doch hat man, bestätigt durch das düstere Album-Cover, sofort das Bauchgefühl: Ach nö, das bringt nix, der Typ hat eh nur Zahlen im Kopf.

Die gleiche Ambivalenz befeuert auch die aktuelle Debatte um ChatGPT. Denn die Konversations-KI – ein reiner Zahlenjongleur wie Braggs Steuerprüfer – hängt scheuklappig-stur ein Wort ans andere und errechnet jedesmal, welches Folgewort wohl am wahrscheinlichsten wäre. Das Ergebnis aber ist geradezu unheimlich: Man weiß zwar, hier agiert nur ein Algorithmus – und hat doch schnell das Bauchgefühl, sich mit einem richtigen Menschen zu unterhalten. Auch wenn der sich mitunter irrt oder besserwisserisch angebliche Fakten herbeihalluziniert.

Seit das US-Unternehmen OpenAI (AI: Artificial Intelligence, also KI) letzten November ChatGPT als Beta-Version allgemein zugänglich machte, tobt eine Diskussion von der Fachwelt bis zu den Massenmedien, wann wohl KI den Menschen bei Aufgabe X oder Berufsbild Y ersetzen wird. Beschäftigte unterschiedlichster Branchen sehen, auf den großen Sprung vorwärts wartend, bereits ihren Arbeitsplatz durch KI bedroht – der nette Chatbot mutiert zum Terminator. Mit solchen Sorgen konfrontiert, geben KI-Fachleute hingegen die kurze Antwort: Nicht KI wird den Menschen aus dem Rennen kicken – sondern der Berufstätige, der mit KI umzugehen versteht, wird denjenigen Konkurrenten verdrängen, der den Umgang mit KI nicht beherrscht.

Seltsame Dinge passieren

Dank Recherchen von Security-Forschern wissen wir: In der Cybercrime-Szene passieren seltsame Dinge – Cyberkriminalität ist heute sogar weitgehend eine Industrie wie jede andere. Wohlorganisierte Angreifergruppierungen (sogenannte Advanced Persistent Threats, kurz APTs) wie etwa die Ransomware-Gruppen haben feste Arbeitszeiten, zahlen reguläre Gehälter (obschon auch mal in Bitcoin) und sind arbeitsteilig aufgestellt – der eine schreibt Ransomware-Schadcode, der andere Exploits, wieder ein anderer verwaltet die Server und pflegt die Darkweb-Site, auf der man die Interna zahlungsunwilliger Opfer veröffentlicht. Und Broker liefern Login-Daten potenzieller Opfer „as a Service“. Sollten also – oh Schreck! – gar auch lukrative Cybercrime-Jobs von KI bedroht sein?

Laut Experten sind Cyberkriminelle längst damit befasst, in ihrem bösen Spiel die Torpfosten zu verschieben, indem sie mit ChatGPT experimentieren. „Mittlerweile loten nicht nur normale Nutzer, sondern auch immer häufiger Cyberkriminelle die zahlreichen Möglichkeiten der neuen Technologie aus“, sagt Wolfgang Kurz, Geschäftsführer des MSSPs (Managed Security Service Provider) Indevis aus München. Auf Knopfdruck könne ChatGPT zum Beispiel „täuschend echte Phishing-Mails“ verfassen.

Chester Wisniewski, Field CTO Applied Research beim britischen Security-Anbieter Sophos, umreißt das Problem so: „Letztendlich liefern die immer besseren KI-Chatbots ein kostenloses Upgrade für alle Arten von Social-Engineering-Angriffen“ – also für das Ausnutzen menschlicher Schwächen.

Security-Forscher von Check Point wiederum demonstrierten kurz nach Veröffentlichung von ChatGPT, dass man – aller Sicherheitsmaßnahmen von OpenAI zum Trotz – mit der KI Phishing-E-Mails und Schadcode für automatisierte Angriffe erstellen kann. Und Fachleute von CyberArk legten dar, dass sich ChatGPT sogar missbrauchen lässt, um polymorphe, also anpassungsfähige Malware zu erstellen.

„Mit ChatGPT sind selbst technisch wenig bedarfte Cyberkriminelle in der Lage, automatisiert unzählige Varianten einer solchen Schadsoftware zu erzeugen und zu verbreiten“, warnt Indevis-Chef Kurz. Der renommierte Security-Experte Bruce Schneier wiederum urteilt: „ChatGPT-erzeugter Code ist nicht so toll, aber es ist ein Anfang. Und die Technologie wird immer besser werden.“ Hinzu kommt, dass die Cybercrime-Industrie – wie jede andere Branche auch – generative KI künftig nutzen dürfte, um interne Betriebsabläufe zu automatisieren und zu beschleunigen.

Kriegsgerüchte

Gerade in den aktuellen Kriegszeiten, in der einige sogar über drohende Cyberkriegsführung munkeln, stellt sich die Frage: Wie lassen sich künftige KI-gestützte Cyberangriffe abwehren? Fachleute raten hier zu einem Bündel an Maßnahmen: Website- und Plattformbetreibern legen sie nahe, Bots mittels Captchas möglichst außen vor zu halten.

Unternehmen wiederum sollten ChatGPT in ihr Security-Awareness-Training mit aufnehmen, eine Mehr-Faktor-Authentifizierung (MFA) einführen und den Mythos des Vertrauens in Firewall und VPN durch ein Zero-Trust-Sicherheitsmodell ersetzen. Zudem gelte es, die IT-Umgebung laufend durchgängig zu überwachen und Workflows wie auch Automatismen zur Reaktion im Ernstfall zu etablieren.

In mehrfacher Hinsicht kommt hier ebenfalls KI zum Einsatz. So nutzen moderne Endgeräte – und darauf aufbauende MFA-Lösungen – KI für Fingerabdruck- und Gesichtsscans. „Zukunftsweisende Security-Systeme verwenden bereits seit einiger Zeit KI als Unterstützung bei der Bedrohungserkennung“, sagt Wolfgang Kurz von Indevis. „Anhand von Machine Learning versuchen sie, Codeschnipsel zu identifizieren, die denen bekannter Malware ähneln.“

Lösungen zur Angriffserkennung und -abwehr – diese Saison unter dem Label XDR (Extended Detection and Response) vermarktet – wiederum ziehen KI in der Form von maschinellem Lernen (ML) dazu heran, auffällige Verhaltensausreißer oder Clusterbildungen im Netzwerkverkehr aufzuspüren. „Am Ende gewinnt dann die KI mit dem besseren Algorithmus“, resümiert Kurz.

Die Million Dinge, die nie passiert sind

Die IT-Security-Branche steht damit vor einer enormen Herausforderung: Sie muss gegen die verbreitete „Aber bisher ist doch auch nichts passiert“-Haltung ankämpfen und die Notwendigkeit vermitteln, zur Abwehr moderner Bedrohungen auf nicht minder moderne Technik zu bauen. Immer noch mehr Security-Reports mit immer noch erschreckenderen Zahlen helfen dabei allerdings offenbar ebenso wenig wie der branchenübliche, von Anglizismen und Akronymen durchseuchte Fachjargon, der Entscheider außerhalb der IT nur verwirrt und abschreckt.

So erklärte bei einer Kaspersky-Umfrage letzten Herbst knapp die Hälfte (48 Prozent) der befragten Sicherheitsfachleute auf Führungsebene: Cybersecurity-Fachjargon und verwirrende Branchenbegriffe sind für die Führungsetage das größte Hindernis beim Verständnis von Cybersicherheit und dem Umgang damit. Und für etwas, das der Chef nicht versteht, stellt er natürlich ungern Budget bereit. Dann ist eine Kompromittierung nur noch ein Unfall, der darauf wartet zu passieren.

Zum Security-Slang, der für Verwirrung sorgt, zählen laut der Umfrage übrigens nicht nur Kürzel wie IoC (Indicator of Compromise, Hinweis auf einen Sicherheitsvorfall) oder Yara (ein Malware-Forschungs-Regelwerk), sondern auch für Security-Teams alltägliche Begriffe wie Ransomware (Erpressungssoftware). Kleine Pointe am Rande: Das Akronym „Yara“ steht für „Yet Another Ridiculous Acronym“ (Schon wieder ein albernes Akronym).

Muss ich Ihnen erst ein Bild malen?

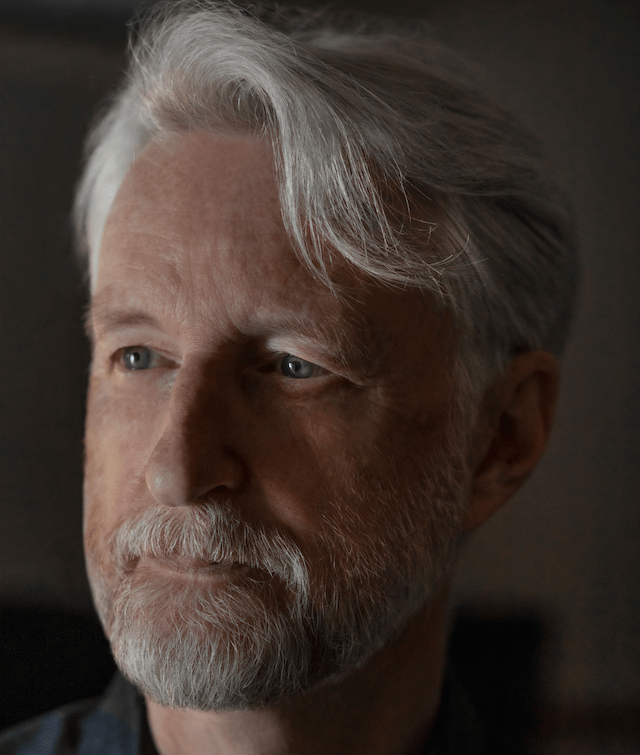

Die Security-Branche ist so verliebt in ihren Fachjargon mit den immer neuen Fachbegriffen und Kürzeln, dass sie sich dadurch selbst im Weg steht – und damit schlimmstenfalls sogar die Risikolage weiter verschärft. Schade eigentlich, dass Billy Bragg (im Bild oben) kein Security-Consultant ist. Denn der Liedermacher findet stets klare, einprägsame Worte – so beispielsweise 2021, als der Covid-Lockdown in England heftig umstritten war, hatte ihn doch eine Regierung verordnet, die selbst Partys feierte. Zwar machte ein neues England voller Auftrittsbeschränkungen dem Live-Musiker Bragg das Leben schwer, doch umso eleganter plädierte er für gegenseitige Rücksichtnahme: Er veröffentlichte ein melancholisches Liebeslied namens „I Will Be Your Shield“ (Ich werde dein Schutzschild sein) – damit war alles gesagt.

Der Protestsänger, heute als 65-Jähriger längst selbst im Großvater-Alter und mit silbergrauem Hipster-Bart, propagiert weiterhin unverdrossen zu Geschrammel auf angezerrter E-Gitarre seinen „Sozialismus des Herzens“ – exakt 40 Jahre nach Veröffentlichung seines ersten Albums namens „Life’s a Riot with Spy vs. Spy“ (Das Leben ist ein Tumult, in dem Spion gegen Spion kämpft). In unserer KI-Ära – spätestens seit dem phänomenalen Erfolg des OpenAI-Chatbots ChatGPT – müsste es wohl besser heißen: „Life’s a Riot with AI vs. AI“. Vielleicht wäre das ja die dringend benötigte griffige Formel, mit der Security-Dienstleister ihren Kunden erläutern könnten, dass man einer KI-gestützten Angriffsfront nur mit ebenfalls KI-basierter Abwehr wirkungsvoll entgegentreten kann.

Der dadurch anstehende Generationssprung in der IT-Security dürfte allerdings viele Unternehmen und Behörden hoffnungslos überfordern, trifft hier doch akuter Fachkräftemangel auf exponentiellen KI-Fortschritt. Dies eröffnet einen riesigen Markt für MSSPs, die das laufende Monitoring und die Angriffsabwehr übernehmen. Denn sie können ihre Kunden trösten: „Machen Sie sich keine Sorgen! Ich werde Ihr Schutzschild sein.“

(Dieser Beitrag erschien erstmals in Connect Channel 04/2023.)

Lust auf mehr Artikel dieser Art? Nichts leichter als das! Einfach hier den IT Info 2 Go Newsletter abonnieren! (Achtung: Double-Opt-in wg. DSGVO! Es kommt also eine E-Mail mit Link zur Bestätigung, deshalb bitte ggf. Spam-Ordner checken!)

Bild: Cooking Vinyl/Jill Furmanovsky